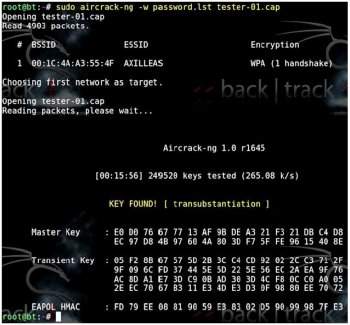

É possível eliminar o oxigênio das duas moléculas com um procedimento químico

Leandro Müller / 20/11/2014

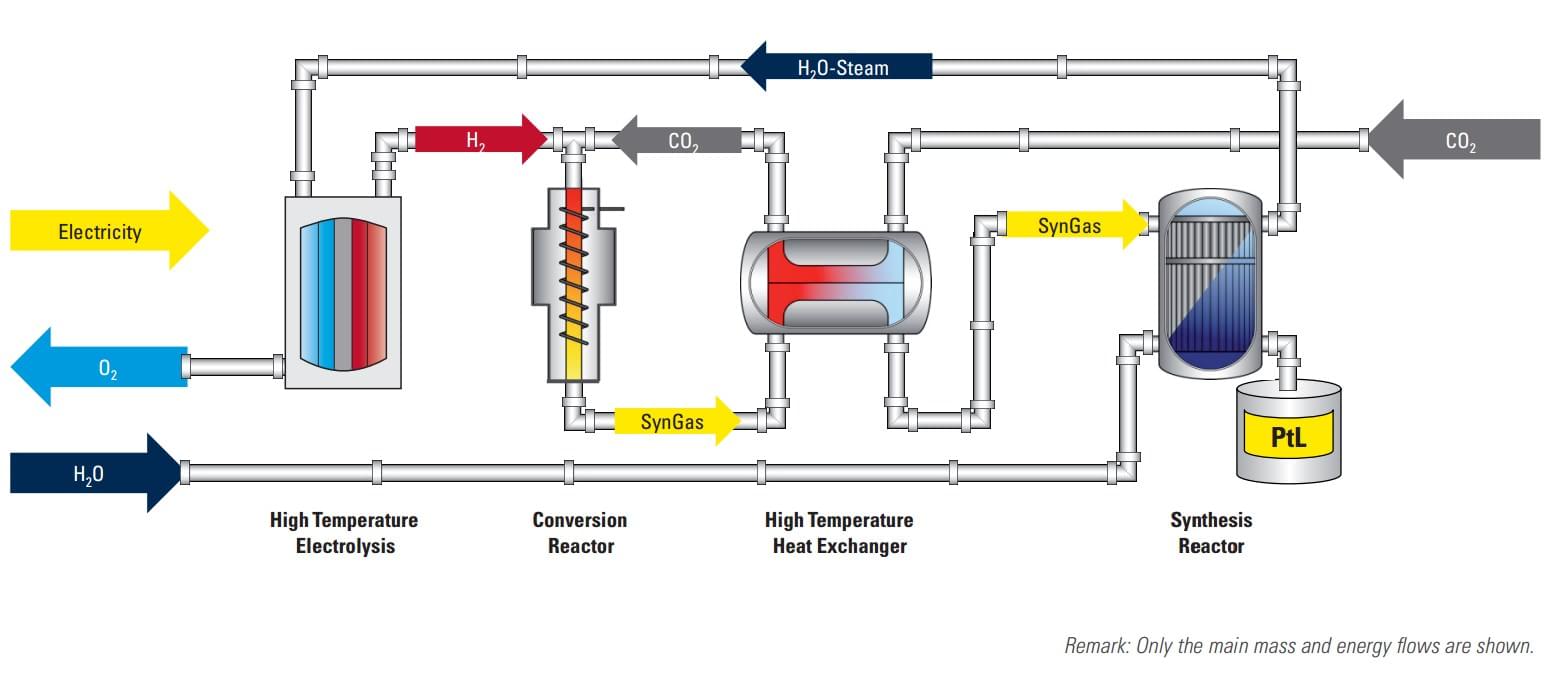

Uma empresa alemã chamada Sunfire GmbH anunciou sua mais nova

criação: uma tecnologia chamada “Power to Liquid” que consegue

transformar água e gás carbônico em gasolina sintética. Cada molécula do

líquido (H2O) e do gás (CO2) passa por um procedimento em que os átomos

de oxigênio são removidos de suas fórmulas. O que resta das duas cria a

partícula básica para uma gasolina alternativa (-CH2-).

Esse procedimento requer bastante energia para ser iniciado e

concluído, mas também gera muito calor. Esse calor pode ser aproveitado e

transformado novamente em eletricidade, o que torna a sintetização da

gasolina da Sunfire muito mais eficiente do que o refinamento do

petróleo. A empresa comenta que a eficiência energética do combustível

chega a 70% por conta desse reaproveitamento.

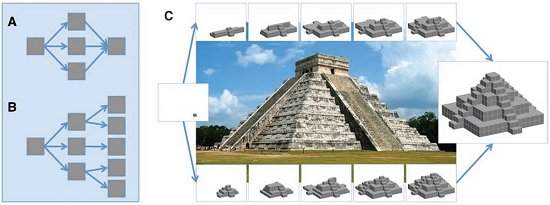

Os detalhes mais minuciosos sobre como isso pode ser feito em larga

escala não são revelados, naturalmente, mas a companhia até criou um

esquema para mostrar como sua tecnologia consegue resultar na produção

de gasolina a partir de duas moléculas massivamente presentes no

planeta.

Impacto ambiental

Você pode estar imaginando que os problemas climáticos atuais estão

sendo causados mais pela queima da gasolina do que pela produção da

mesma. Então, porque produzir o combustível de forma sintética ajudaria

de alguma forma? É importante lembrar que a “matéria-prima” da gasolina

sintética é o gás carbônico (CO2), um dos seus principais subprodutos.

Assim, à medida que a gasolina sintética é queimada em motores de

carros tradicionais, a produção da mesma poderia remover boa parte do

CO2 que ela joga na atmosfera, em teoria.

A substituição do petróleo por uma matéria-prima mais limpa para a

produção de combustíveis seria um grande passo na caminhada para

melhorar as condições do planeta, mas ainda não há informações e dados

práticos acerca da gasolina da Sunfire. Não há também expectativas sobre

quando ela poderia começar a aparecer no mercado.

![A evolução dos ícones ao longo do tempo [infográfico]](http://img.ibxk.com.br/2014/2/materias/11419017711161539-t640.jpg)

![A evolução dos ícones ao longo do tempo [infográfico]](http://img.ibxk.com.br/2014/2/materias/1141901771116243-t640.jpg)

![A evolução dos ícones ao longo do tempo [infográfico]](http://img.ibxk.com.br/2014/2/materias/11419017711161644-t640.jpg)

![A evolução dos ícones ao longo do tempo [infográfico]](http://img.ibxk.com.br/2014/2/materias/11419017711161734-t640.jpg)

![A evolução dos ícones ao longo do tempo [infográfico]](http://img.ibxk.com.br/2014/2/materias/11419017711162029-t640.jpg)

![A evolução dos ícones ao longo do tempo [infográfico]](http://img.ibxk.com.br/2014/2/materias/11419017711162440-t640.jpg)

![A evolução dos ícones ao longo do tempo [infográfico]](http://img.ibxk.com.br/2014/2/materias/1141901771116228-t640.jpg)

![A evolução dos ícones ao longo do tempo [infográfico]](http://img.ibxk.com.br/2014/2/materias/11419017711165959-t640.jpg)