Por Carlos E. Morimoto em 8 de agosto de 2007 às 09h21

Introdução

Os processadores Quânticos parecem ser mesmo o futuro da computação. A arquitetura atual, que consiste em construir processadores usando transístores, fatalmente chegará ao seu limite dentro de poucos anos. Será necessária então uma arquitetura mais eficiente. Por que não substituir os transístores por átomos? Os processadores Quânticos tem potencial para serem eficientes ao ponto de realizarem em poucos segundos o que os processadores atuais não poderiam nem em milhões de anos.O porquê dos processadores Quânticos

Realmente, os projetistas de microprocessadores vem fazendo um grande trabalho. Nas três últimas décadas, desde o aparecimento do Intel 4004, o primeiro microprocessador do mundo, tivemos um aumento absurdo na velocidade de processamento. Para se ter uma idéia, o i8088, o processador usado no XT, lançado em 79, tinha um poder de processamento estimado em apenas 0.25 megaflop, ou seja, apenas 250.000 operações por segundo. Um Pentium 100 já processa 200 megaflops, 200 milhões de operações, enquanto um Athlon de 1.1 GHz processa quase 10 gigaflops, 40 mil vezes mais rápido que o 8088.

O problema é que todos os processadores atuais tem uma limitação em comum, são compostos por transístores. A solução para produzir chips cada vez mais rápidos tem sido diminuir cada vez mais o tamanho dos transístores que os compõe. Os primeiros transístores, que surgiram na década de 60, eram mais ou menos do tamanho da cabeça de um fósforo, enquanto os atuais medem apenas 0.18 mícron (1 mícron = 0.001 milímetro). Porém, estamos nos aproximando dos limites físicos da matéria, para continuarem avançando, será preciso abandonar o uso de transístores e partir para alguma estrutura mais eficiente. O futuro dos processadores parece depender mesmo dos processadores quânticos.

Até algum tempo atrás, não se acreditava que seria possível produzir transístores medindo menos que 0.15 mícron, que já são realidade. A Intel surpreendeu ao divulgar planos de se produzir chips com transístores de 0.07 mícron até 2005. Pode ser que ainda consigam produzir transístores de 0.05 ou quem sabe 0.03 mícron, mas seria impossível ir além disso. Pra se ter uma idéia, a 0.07 mícron cada gate, ou seja, cada um dos três filamentos que compõe cada transístor tem o equivalente a apenas 3 átomos de ouro de espessura! Seria realmente um milagre conseguir transístores de 0.03, onde cada filamento teria apenas o equivalente a um único átomo de ouro espessura, o que corresponde a alguns poucos átomos de silício, mas seria fisicamente impossível ir muito atém disso.

A tecnologia mais promissora para substituir os transístores ainda são os famosos processadores Quânticos.

Como funcionam

A idéia de usar átomos para processar dados não é nova, existem pesquisas neste sentido desde o início da década de 80, mas eram apenas teorias vagas, que apenas atualmente começam a tomar forma.

Num processador quântico, temos átomos ao invés de transístores. Ao invés de bits temos bits quânticos, ou qubits. A idéia fundamental é que num átomo, a rotação de cada elétron corresponde a um pequeno movimento magnético, que pode ser controlado caso o átomo seja colocado sobre uma superfície magnética suficientemente sensível

Uma peculiaridade interessante é que enquanto um transístor permite apenas dois estados, ou seja, ligado ou desligado, cada qubit possui três estados diferentes. Dois estados são determinados pela rotação dos elétrons (horário ou anti-horário), enquanto o terceiro é uma característica bastante peculiar dentro do mundo quântico, onde os elétrons podem girar simultâneamente nos dois sentidos. Sim, parece estranho, e é por isso que existem tantos cientitas pesquisando isso, mas de qualquer forma, combinado com os dois estados anteriores temos um total de 4 estados possíveis, o que permite que cada qubit processe ou armazene dois bits simultaneamente.

Isto permite ampliar exponencialmente a capacidade dos processadores quânticos, já que dois qubis correspondem a 4 bits, 3 qubits correspondem a 8 bits e 5 qubits correspondem a 32 bits. 10 qubits seriam suficientes para 1024 bits, enquanto 20 correspondem a mais de um milhão. Esta pode ser a grande chave para aumentar de forma inimaginável tanto a potência dos processadores quanto a capacidade dos dispositivos de armazenamento de memória. Não estou falando de processadores operando a 100 ou 500 GHz, mas de computadores capazes de resolver em poucos segundos cálculos que um processador atual demoraria milhões de anos para resolver. Seria potência suficiente para construir um mainframe capaz de calcular todas as variáveis possíveis de surgimento de vida em um planeta ao longo de bilhões de anos, por exemplo :-)

Aplicações

O brutal poder de processamento que pode ser atingido pelos processadores Quânticos seria extremamente útil tanto para pesquisas científicas, onde naturalmente estes ultra-computadores iriam debutar, quanto para aplicações comerciais de realidade virtual e inteligência artificial, que sem dúvida serão as modas deste século. Os jogos poderiam ser suficientemente reais para conter vários personagens que realmente interagissem com o jogador, conversando (ou sabe-se lá o que mais :-), e agindo de acordo com as ações do jogador, como num RPG quase real. Um computador quântico sozinho poderia controlar em tempo real centenas destes personagens. Reconhecimento de voz e gestos já seria algo trivial.

Sem dúvida, teríamos gigantescos avanços em praticamente todos os campos, finalmente poderíamos ter códigos de encriptação realmente seguros, pesquisas em gigantescos bancos de dados usando algoritmos inteligentes e traços de inteligência artificial poderiam ser feitas quase instantaneamente, a transmissão de dados poderia alcançar velocidades da ordem de vários Terabytes (ou Petabytes) por segundo usando fibras ópticas de alta densidade e roteadores quânticos, capazes de lidar com esta quantidade de informação. Seria o suficiente para a Internet transformar-se num mundo virtual, onde as pessoas possam encarnar avatars e se relacionar com voz, gestos e até toque, como no mundo real. Seria uma evolução dos chats atuais.

A grande pergunta é quando. Ninguém sabe com certeza o quão rápido as pesquisas nesta área poderão avançar. Pode demorar cem anos para vermos estas aplicações que descrevi, ou pode demorar apenas duas ou três décadas. Como é um campo muito novo, não se sabem de onde podem surgir as soluções para os enormes problemas que ainda dificultam a vida dos pesquisadores.

Como funcionam

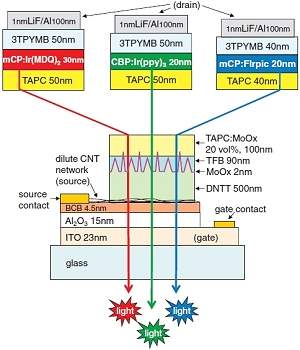

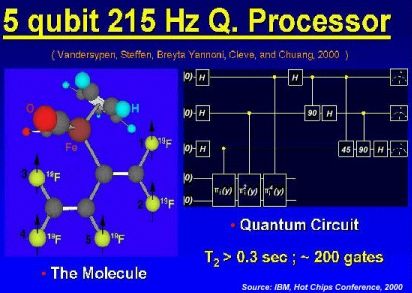

Os primeiros computadores quânticos já são realidade, a IBM por exemplo anunciou seu primeiro chip Quântico no início deste ano (2001), na 12º Conferência anual na universidade de Palo Alto. Ainda é um projeto bastante rudimentar, possui apenas 5 qubits, trabalha a apenas 215 Hz, e necessita de um aparato gigantesco de equipamentos para funcionar, mas já mostra que é realmente possível produzir processadores Quânticos. Veja um diagrama do computador na figura abaixo:

Neste diagrama podemos ver que o chip é na verdade uma molécula. Os cinco átomos verde claro são os que realmente tem função, enquanto os demais servem apenas para estabiliza-los. Como vimos anteriormente, cada qubit é capaz de processar 2 bits de dados por vez, 5 qubits correspondem a 32 bits. Sim, com apenas 5 átomos temos um processador de 32 bits funcional.

O primeiro problema nesta experiência, e em todas as experiências com processadores quânticos usados atualmente, é como manter esta molécula estável. A solução usada atualmente é conservá-la numa solução altamente resfriada, numa temperatura próxima do zero absoluto. Este sistema porém é incrivelmente caro. Para tornarem-se viáveis comercialmente, os computadores quânticos teriam que superar esta limitação, com modelos que pudessem operar à temperatura ambiente.

O segundo problema é como manipular os átomos que compõe a molécula. Um átomo pode mudar de estado numa velocidade surpreendente, mas um átomo sozinho não tem como adivinhar quais estados queremos que ele assuma. Para manipular átomos, precisamos usar partículas ainda menores que eles. A solução encontrada pelo projetistas da IBM foi usar radiação, num sistema semelhante à ressonância magnética que temos nos hospitais, porém muito mais preciso. Este sistema possui dois problemas, primeiro é o fato de ser muito caro, um aparelho destes não sai por menos de 5 milhões de dólares. O segundo problema é o fato da técnica ser muito lenta, o que justifica o fato do protótipo da IBM operar a apenas 215 Hz, milhões de vezes mais lentamente que qualquer processador atual, que já estão na casa dos Gigahertz. Mais um obstáculo que precisa ser superando antes dos Quânticos tornarem-se viáveis comercialmente.

Novas esperanças

Como vimos, os processadores Quânticos experimentais desenvolvidos até agora são incrivelmente lentos, algo normal para uma tecnologia emergente, mas o pior, precisam de equipamentos incrivelmente sofisticados, e caros para funcionar. Nada parecido com um processador Intel ou AMD que pode ser facilmente encapsulado e trabalha à temperatura ambiente, amparado por um simples cooler.

Os protótipos Quânticos atuais utilizam aparelhos de ressonância magnética nucleares para manipular os estados dos átomos e a (ou as) moléculas precisam ser mantidas a temperaturas próximas do zero absoluto para manterem-se estáveis. Apesar de ajudar os cientistas a estudar a mecânica quântica, um sistema assim jamais seria viável economicamente.

Atualmente o desenvolvimento dos processadores quânticos vem ganhando impulso. As primeiras experiências tinham como objetivo manipular os elétrons, isto provou-se muito problemático, pois os elétrons, por sua pequena massa e pela sua exposição, são extremamente susceptíveis a qualquer influência externa. Surgiu então a idéia de manipular os núcleos dos átomos, o que torna o processo bem mais simples, já que o núcleo é maior e está relativamente isolado do meio externo graças à barreira de elétrons em torno dele.

Mas isto foi apenas parte da solução do problema. Pois de qualquer modo ainda resta desenvolver algum tipo de tecnologia que permita manipular núcleos atômicos. A primeira safra de protótipos utiliza ressonância magnética para isto, uma tecnologia extremamente cara, mas já existe gente desenvolvendo meios bem mais simples de fazer isso.

Os cientistas do laboratório nacional de Los Alamos, nos EUA, divulgaram experiências usando um sistema óptico para manipular prótons. A idéia da nova técnica é que os prótons podem ser usados tanto na forma de partículas (a fim de interagir com os átomos que compõe o sistema quântico), quanto na forma de onda, podendo ser transportados através de um sistema óptico.

Usando a nova técnica, os prótons recebem a função de manipular os átomos que compõe o processador quântico. Por ser uma partícula, um próton pode ser "arremessado" contra o qubit, alterando com o impacto seu movimento. Da mesma forma, um próton pode ser arremessado de forma a ricochetear no qubit. Desta forma o próton é que tem sua trajetória alterada.

A grande sacada é que este próton poderia ser recuperado usando um foto detector, que detectaria o próton na forma de onda, e não de partícula. Calculando a trajetória do próton, é possível recuperar o dado gravado no qubit.

Um problema que surgiu durante as experiências foi o fato deste sistema ser susceptível a um grande número de erros. Para isto os pesquisadores vêm trabalhando em algoritmos de correção de erros, o que permitiria tornar este sistema confiável.

Com tudo o que vem sendo feito é possível que os computadores quânticos tornem-se viáveis muito antes do que se vem esperando. A quinze anos os computadores quânticos eram considerados apenas coisa de ficção científica. Hoje já existem alguns protótipos em funcionamento. A pergunta agora é quando estes sistemas irão tornar-se viáveis. Avanços como o que vimos podem ser a resposta :-)

Fonte: Hardware