Foram anos de avanços até a rede mundial de computadores tornar-se o que é hoje. Conheça o início dessa evolução.

![Infográfico - A história da Internet: pré-década de 60 até anos 80 [infográfico] Infográfico - A história da Internet: pré-década de 60 até anos 80 [infográfico]](http://ibxk.com.br/materias/9847/infografico-tecmundo-9847.jpg)

Quanto tempo você consegue ficar sem internet? Para quem está acostumado a acessá-la diariamente, é difícil imaginar um longo período de tempo sem bate-papos, sites de notícias ou jogos em rede. Mas pare para refletir por um instante: desde a invenção dos computadores, passaram-se décadas sem esses recursos tão simples e essenciais dos quais desfrutamos atualmente.

Essa complexa rede foi evoluindo a partir de diferentes necessidades, como a comunicação instantânea e até o medo da guerra. Foram avanços inicialmente simples e isolados, que foram combinados para melhorar a qualidade e quantidade de dados transmitidos até chegar ao eficiente sistema de conexões que utilizamos hoje.

O Tecmundo preparou um especial sobre o início da trajetória da rede mundial de computadores, agrupando os principais fatos e invenções da criação de nossa querida internet.

Pré-1960

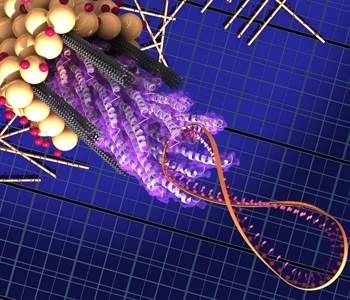

Por séculos, a troca de informações acontecia de pessoa a pessoa ou por documentos em papel. Um grande aliado nessa comunicação foi a criação do telégrafo, um sistema de transmissão de mensagens através de dois pontos graças a ondas de rádio ou fios elétricos.

A primeira mensagem foi transmitida pelo aparelho em 1844, entre as cidades norte-americanas de Baltimore e Washington. A partir dele, o tempo gasto entre a comunicação tornou-se muito menor, mas ainda apresentava falhas. Para a época, entretanto, já era mais do que o suficiente para conectar diferentes regiões.

Outra criação indiretamente relacionada com a rede é a do sistema binário. A codificação de letras do alfabeto em sequências de dígitos binários foi devidamente aperfeiçoada pelo filósofo inglês Francis Bacon, em 1605. Segundo ele, qualquer objeto poderia sofrer codificações. Cerca de meio século depois, o filósofo alemão Gottfried Leibniz criou o sistema binário como o conhecemos hoje, a partir de numerais.

Mas o que isso tem a ver com a rede? É a partir de códigos construídos por esse sistema binário (padronizado com os numerais 0 e 1) que os computadores realizam o processamento de dados, sendo que cada bit corresponde a um dígito dessas sequências. Sem eles, não seria possível nem sequer realizar a leitura dessas informações.

Além disso, não se pode falar do início da internet sem abordar o primeiro computador digital eletrônico, criado em 1946 por cientistas norte-americanos. O ENIAC (Electrical Numerical Integrator and Computer) era uma imensa máquina de realizar cálculos (pesava 30 toneladas e ocupava 180 m²) e pouco tinha de armazenador ou transmissor de dados, funções posteriormente adquiridas pelo computador.

O ENIAC. (Fonte da imagem: Wikimedia Commons)

O ENIAC. (Fonte da imagem: Wikimedia Commons)

A década de 1960

Melhoras na transmissão

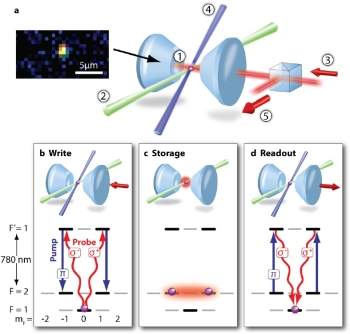

Em 1961, a transmissão de dados ganhou um poderoso conceito: pesquisadores como Vinton Cerf e Robert Kahn iniciam o planejamento do sistema de pacotes, que consiste em repassar dados através da quebra da mensagem em vários blocos, enviados juntamente com as informações necessárias para utilizá-los em conjunto novamente.

Além de aumentar a velocidade da conexão, o sistema torna possível utilizar um mesmo canal para mensagens com destinos diferentes, algo impossível quando os canais eram circuitos reservados. O sucesso da empreitada é comprovado pela utilização desse modo de transmissão até os dias de hoje.

Outro registro importante é a instalação dos nós, os pontos de intersecção de informações, que servem como uma ponte entre máquinas que se comunicam entre si. A partir desses pontos de segurança, a informação não corria riscos de se perder durante o trajeto por falhas no sinal, por exemplo. O primeiro nó foi instalado na Universidade de Los Angeles, em agosto de 1969.

Filha da guerra

A década de 1960 foi um dos períodos mais conturbados da História. A tensão criada pela Guerra Fria, o conflito ideológico entre Estados Unidos e União Soviética, atingia seu ápice. Nenhum confronto bélico entre ambos ocorreu de verdade, entretanto, a maior arma era provocar medo no inimigo.

Desse modo, qualquer triunfo era visto como um passo à frente na disputa pela dominação mundial. A União Soviética, por exemplo, saiu na frente na corrida espacial: lançou em 1957 o primeiro satélite artificial, o Sputnik. Quatro anos depois, Yuri Gagarin era o primeiro ser humano a fazer uma viagem espacial.

Os Estados Unidos buscaram outra estratégia, principalmente através da ARPA (Advanced Research Project Agency, ou Agência de Pesquisas em Projetos Avançados, em tradução literal), um órgão científico e militar criado em 1957 que cuidava dos avanços tecnológicos da potência ocidental e, posteriormente, da primeira rede.

Um dos pioneiros do conceito hoje conhecido por internet foi J.C.R. Licklider, do Instituto Tecnológico de Massachussets (MIT). Foi ele o responsável, em 1962, por difundir a ideia da “rede galáctica”, um conceito ainda abstrato de um sistema que concentraria todos os computadores do planeta em uma única forma de compartilhamento. Com o passar dos anos, essa ambiciosa ideia começou a tomar forma.

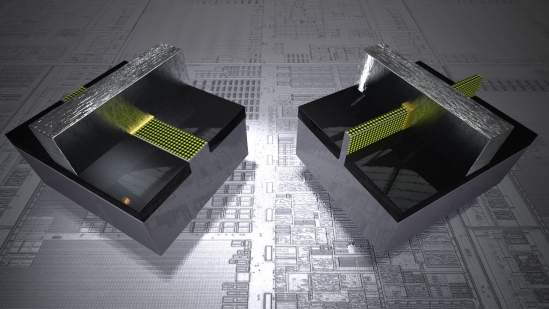

A rede da ARPA

É aí que o medo entra novamente na história: temendo um combate em seu território que acabasse com a comunicação e com todo o trabalho desenvolvido até então, cientistas norte-americanos colocam o plano de Licklider em prática com a ARPANET, uma rede de armazenamento de dados que inicialmente conectou algumas universidades e centros de pesquisa: as sedes da Universidade da Califórnia em Los Angeles e Santa Barbara; o Instituto de Pesquisa de Stanford e a Universidade de Utah.

O início da ARPANET (Fonte da imagem: ARPANET Maps)

O início da ARPANET (Fonte da imagem: ARPANET Maps)

Desse modo, tudo ficaria armazenado virtualmente, sem correr o risco de sofrer danos materiais. Além disso, pouco tempo seria perdido na troca de dados. Em outubro de 1969, a ARPANET teve seu primeiro sucesso ao transmitir uma mensagem através de sua rede, da Universidade de Los Angeles até o instituto em Stanford, em uma distância de quase 650 quilômetros.

Ao mesmo tempo, entretanto, essa tentativa resultou em fracasso: o conteúdo transmitido – a palavra “login” – chegou incompleto ao receptor, pois o sistema caiu antes da recepção da terceira letra do termo enviado.

A década de 1970

Se a década de 1960 serviu para estabilizar as bases da internet, os dez anos seguintes foram para a criação de conceitos básicos da rede.

A década dos primeiros

O primeiro invento que vale ser destacado é o da própria palavra que dá nome à rede. Em meados de 1971, Vinton Cerf e sua equipe de cientistas (reconhecidos como “os pais da internet”) tentavam conectar três redes diferentes em um processo descrito em inglês como interneting. O termo foi abreviado e, aos poucos, imortalizado como sinônimo de toda a rede.

Além disso, surgiram também os emoticons, uma forma de facilitar a expressão de sentimentos nas mensagens virtuais. Em 1979, Kevin MacKenzie utilizou um símbolo para descrever uma ironia em uma mensagem, dando início a uma vasta lista de rostos criados por acentos e outras formas. Já os famosos :-) e :-( surgiram apenas em 1982, em um email do cientista Scott Fahlman.

Mas nem tudo foi benéfico. Em 1971, Bob Thomas criou o que seria uma das maiores dores de cabeça dos usuários de computadores: o vírus. Batizado de The Creeper, a infecção invadia a máquina apenas para apresentar a mensagem "I’m the creeper, catch me if you can!" (“Eu sou assustador, pegue-me se for capaz!”, em tradução livre). No início da informática, a ideia do vírus era apenas quebrar o sistema de segurança de uma máquina para irritar o usuário e consagrar o programador capaz de criar o invasor.

Outro item prejudicial foi o spam, o lixo eletrônico em forma de emails em massa ou de conteúdo duvidoso. Ainda sem esse nome, o ancestral dessa ocorrência a surgiu em 1979, com um convite da Digital Equipment Corporation (DEC) para o lançamento de um produto. A mensagem foi encaminhada para 393 funcionários da ARPA, sendo que vários endereços ainda ficaram de fora por falta de espaço.

Surge o correio eletrônico

O engenheiro Ray Tomlinson começou a desenvolver o hoje indispensável email em 1971. A ARPANET já possuía alguns métodos de transmissão de mensagens entre o mesmo computador, mas faltava um sistema simples e que integrasse toda a ARPANET.

Para tornar isso possível, Tomlinson combinou um aplicativo de troca de mensagens chamado SNDMSG com um protocolo de transferência de arquivos, o CYPNET, possibilitando a transmissão em rede. Já o símbolo @ foi incorporado tempos depois com o mesmo objetivo que conhecemos hoje: separar o nome de usuário e seu servidor.

Para tornar isso possível, Tomlinson combinou um aplicativo de troca de mensagens chamado SNDMSG com um protocolo de transferência de arquivos, o CYPNET, possibilitando a transmissão em rede. Já o símbolo @ foi incorporado tempos depois com o mesmo objetivo que conhecemos hoje: separar o nome de usuário e seu servidor.

Mudança de protocolo

Entre todas as mudanças ocorridas na década de 1970, a que mais contribuiu para o amadurecimento da internet foi a criação do TCP/IP (Transmission Control Protocol / Internet Protocol), o protocolo padrão para transmissão de dados usado até hoje. Ele é dividido em camadas, cada uma com tarefas específicas, dependendo de sua proximidade com a rede ou o destinatário.

O IP é o responsável pelo endereçamento dos pacotes de dados para os demais protocolos. Já o TCP garante a continuidade do fluxo de informação, cuidando para que o processo ocorra sem problemas.

O método desenvolvido por Vinton Cerf e sua equipe surgiu para substituir o Network Control Protocol (NCP), que já estava obsoleto na época e se limitava a controlar a comunicação entre os computadores na ARPANET, sem corrigir falhas no envio. Já com o TCP/IP, qualquer mensagem transmitida de forma errada é rapidamente reenviada. A oficialização dele como protocolo como único na ARPANET, entretanto, só ocorreu em 1983.

Fora do eixo

Ainda nessa década, começou o compartilhamento da tecnologia providenciada pela ARPANET. Em 1973, foi realizada a primeira conexão entre dois continentes: a NORSAR (Norwegian Seismic Array) ligou-se à ARPANET. Pouco depois, a University College of London recebeu a integração.

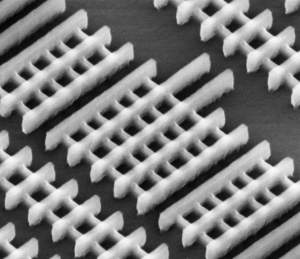

Além disso, o número de servidores nos Estados Unidos aumentou consideravelmente. Na imagem abaixo, é possível conferir todos os terminais da agência em 1977, bem diferente dos quatro pontos existentes quando a ARPANET começou suas atividades.

A ARPANET em 1977. (Fonte da imagem: ARPANET Maps)

A ARPANET em 1977. (Fonte da imagem: ARPANET Maps)

Outra criação interessante foi a Usenet, precursora dos fóruns de discussão e que iniciou o processo que tornou a internet interessante também para quem não estava interessado na área científica. Em 1979, Tom Truscott e Jim Ellis interligaram computadores em uma rede de compartilhamento de notícias e artigos divididos por grupos de interesse: se você gostasse de ficção científica, por exemplo, poderia receber apenas as novidades sobre tal tema.

A década de 1980

A internet já estava bastante desenvolvida. Programadores expandiam as fronteiras da rede, criando novas funções para a revolucionária invenção que chegava ao alcance da população em geral.

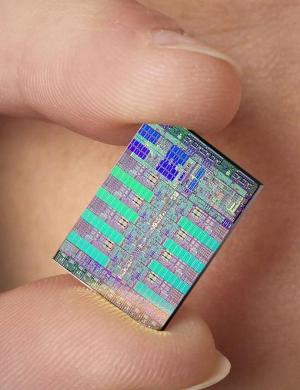

A invasão do computador pessoal

O conceito de uma máquina individual e para uso casual ainda engatinhava na indústria. A ideia foi definitivamente reforçada com o lançamento do PC da IBM, em 1981. Seu estilo padrão foi copiado por inúmeras empresas ao longo dos anos, praticamente padronizando o formato e a composição dos computadores de mesa.

A parceria com a Microsoft (que forneceu o sistema operacional para o PC) e a concorrência com a Apple (que possuía conceitos menos imitados) ditaram o ritmo de crescimento dessanova geração de computadores.

Ascensão e queda da ARPANET

Com o passar dos anos, o número de nós e usuários da ARPANET foi crescendo e, com o enfraquecimento da tensão causada pela Guerra Fria, ela perdeu parte do caráter militar. Por seu potencial, entretanto, ela foi dividida em 1983 na recém-criada MILNET, que cuidaria apenas da parte bélica, enquanto o que restou da ARPANET seria utilizado a partir de interesses científicos.

Esse segmento mais popular, que foi desativado em 1989,foi o que teve maior desenvolvimento, servindo de base para as inúmeras redes conectadas entre si que conhecemos hoje como internet.

Oi, quer teclar?

No final de década de 1980, surge outra criação que não faz mais tanto sucesso, mas ajudou a originar, por exemplo, os famosos mensageiros instantâneos: as salas de bate-papo. Mais direta e informal que os emails e concentrando ao mesmo tempo vários usuários com os mesmo interesses, essa forma de comunicação teve sua revolução em 1988, com o desenvolvimento do IRC pelo finlandês Jarkko Oikarinen para transmitir notícias durante a Guerra do Golfo e em outros conflitos.

Sigla para Internet Relay Chat, o IRC é uma rede de servidores que hospedam as várias salas de conversa. Através de comandos simples, era possível procurar listas específicas, trocar de apelido e interagir com outros usuários.

O futuro estava próximo

Na mudança de década, a internet já estava consolidada como uma das grandes forças da tecnologia. O futuro, entretanto, guardava ainda mais surpresas e novidades para esse serviço de rede. Em 1989, Tim Berners-Lee propôs oficialmente um ambicioso projeto de hipertextos para dinamizar a passagem de um texto a outro de forma mais rápida e dinâmica, em um sistema que ficou conhecido como World Wide Web – o WWW, que entrou em funcionamento na década seguinte.

O especial do Tecmundo sobre a história da internet continua em breve, com artigos e infográficos sobre as demais décadas da rede. Fique ligado!

Fonte: Tecmundo

![Infográfico - A história da Internet: pré-década de 60 até anos 80 [infográfico] Infográfico - A história da Internet: pré-década de 60 até anos 80 [infográfico]](http://ibxk.com.br/materias/9847/infografico-tecmundo-9847.jpg)

O ENIAC. (Fonte da imagem:

O ENIAC. (Fonte da imagem:

O início da ARPANET (Fonte da imagem:

O início da ARPANET (Fonte da imagem:

Para tornar isso possível, Tomlinson combinou um aplicativo de troca de mensagens chamado SNDMSG com um protocolo de transferência de arquivos, o CYPNET, possibilitando a transmissão em rede. Já o símbolo @ foi incorporado tempos depois com o mesmo objetivo que conhecemos hoje: separar o nome de usuário e seu servidor.

Para tornar isso possível, Tomlinson combinou um aplicativo de troca de mensagens chamado SNDMSG com um protocolo de transferência de arquivos, o CYPNET, possibilitando a transmissão em rede. Já o símbolo @ foi incorporado tempos depois com o mesmo objetivo que conhecemos hoje: separar o nome de usuário e seu servidor. A ARPANET em 1977. (Fonte da imagem:

A ARPANET em 1977. (Fonte da imagem:

![Infográfico - Como funciona a fibra ótica [infográfico] Infográfico - Como funciona a fibra ótica [infográfico]](http://ibxk.com.br/materias/9862/infografico-tecmundo-9862.jpg)

(Fonte da imagem:

(Fonte da imagem:

(Fonte da imagem:

(Fonte da imagem: