Limitações tecnológicas estão obrigando empresas como AMD e Intel a abandonar o foco em poder bruto para continuar evoluindo seus produtos.

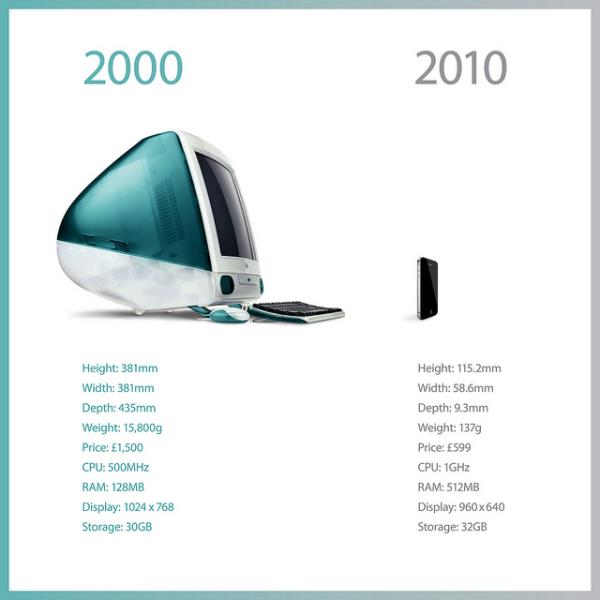

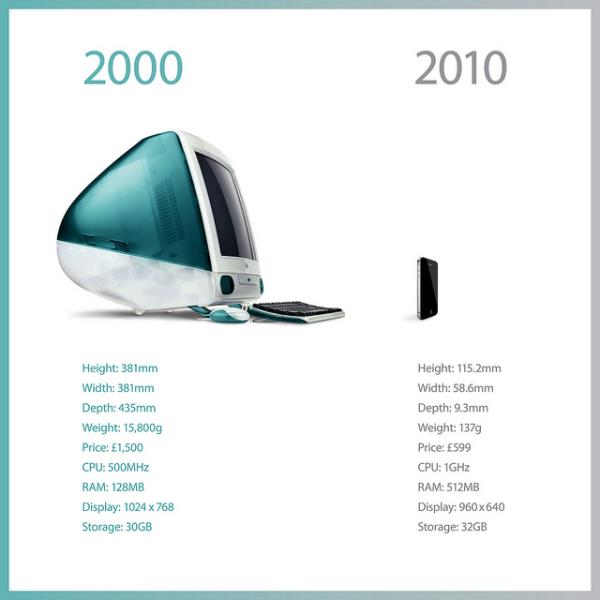

(Fonte da imagem: Reprodução/MemeBurn)

(Fonte da imagem: Reprodução/MemeBurn)

Um dos motivos pelos quais o mercado de computadores se mostra intimidante para muitas pessoas é a rápida evolução pela qual ele passa de tempos em tempos. Não é incomum ouvir quem fale que não vale a pena investir na compra de uma máquina top de linha, já que em questão de um mês vai estar disponível no mercado um produto com o dobro da capacidade e o mesmo preço.

Embora em certo momento essa frase até fizesse sentido, não é possível dizer que ela se aplique ao mercado atual. Apesar de fabricantes continuarem investindo no desenvolvimento de novas tecnologias, o ritmo na evolução de CPUs tem sido de somente 10% ao ano — nada comparado aos ganhos anuais de 60% registrados em certo momento da indústria.

O principal responsável por isso é a estagnação da conhecida “Lei de Moore”, que durante muito tempo ditou os avanços do mundo da tecnologia. Após décadas de validade, essa regra finalmente parece ter chegado a seu limite, o que deve obrigar companhias a investir em novos meios de continuar competitivas e de convencer o consumidor a investir em produtos novos.

O que é a Lei de Moore?

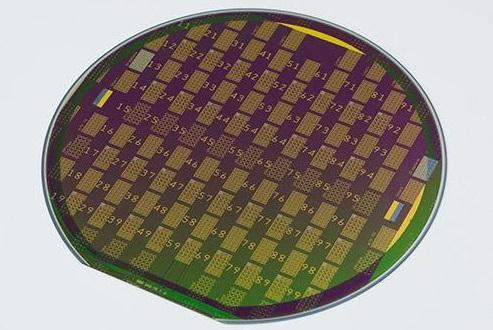

Cunhada em 1965 por Gordon Moore, cofundador da Intel, a Lei de Moore dita que o número de transistores em um chip tende a dobrar a cada ano — período que foi corrigido para dois anos em 1975. Porém, a forma mais conhecida dessa regra é responsabilidade de David House, um executivo da empresa que afirmou que o tempo de transição correto é de 18 meses.

(Fonte da imagem: Reprodução/MemeBurn)

(Fonte da imagem: Reprodução/MemeBurn)

Na prática, o mercado tem mostrado que produtos com o dobro da capacidade de seus antecessores estão disponíveis aos consumidores a cada 20 meses. Apesar de esse ciclo ter se provado verdadeiro durante vários anos, tudo indica que ele está próximo de terminar, já que estamos cada vez mais perto de alcançar o número-limite de elétrons que podem ser colocados em uma área determinada.

Uma lei em crise

“Quando começamos, tínhamos cerca de 1 milhão de elétrons por células... Agora temos somente algumas poucas centenas”, afirma Eli Harari, CEO da Sandisk. Ele admite que esse ciclo não pode continuar para sempre e que não deve demorar muito para que ele seja esgotado. “Não podemos ter menos de um (elétron)”.

Bernie Meyerson, da IBM, concorda com essa afirmação e explica de forma sucinta as regras com as quais a indústria tem que lidar: “1) átomos não são escalonáveis; 2) dispositivos de silício entram no campo da ‘mecânica quântica’ em dimensões de cerca de 7 nanômetros e 3) a luz está se mostrando muito lenta, enquanto os sinais elétricos estão ainda mais lentos”.

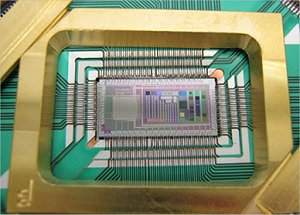

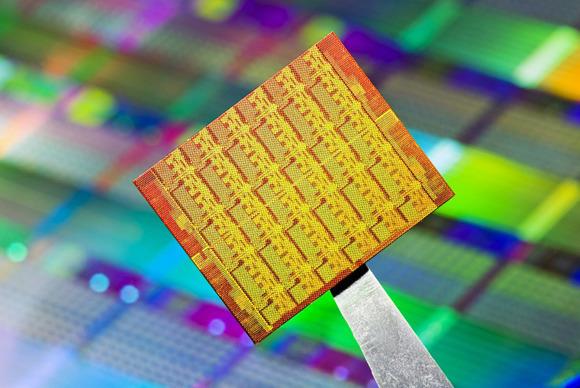

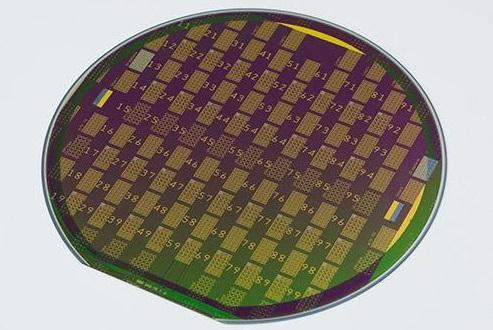

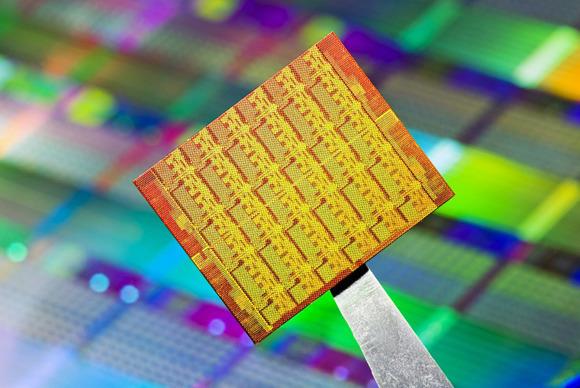

(Fonte da imagem: Divulgação/Intel)

(Fonte da imagem: Divulgação/Intel)

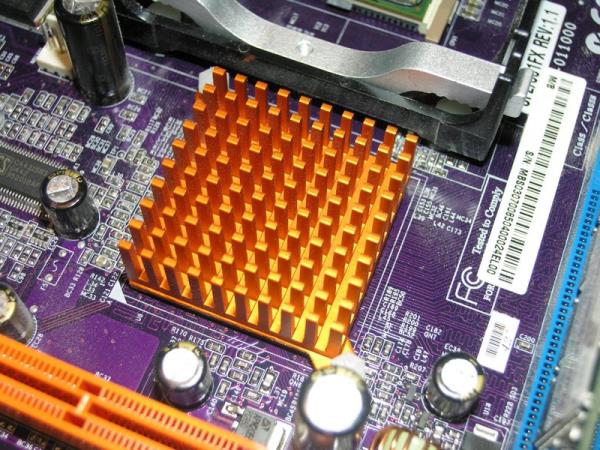

O conhecimento de que a Lei de Moore eventualmente será esgotada já faz parte da indústria há mais de uma década. Prova disso é a transição que companhias como a AMD e a Intel fizeram para as arquiteturas baseadas em múltiplos núcleos de processamento a partir do início dos anos 2000, já que investir em CPUs individuais com clocks cada vez maiores estava se mostrando um processo pouco eficiente e bastante propenso ao superaquecimento.

Para tornar mais complicado o trabalho dessas fabricantes, desenvolvedores de software se mostraram capazes de encontrar meios de usar rapidamente toda a potência que era oferecida pelos novos chips. Segundo a Lei de May, a eficiência dos aplicativos diminui pela metade a cada 18 meses — ou seja, toda vez que o poder de processamento era aumentado em 10 vezes, softwares passavam a exigir 10 vezes mais trabalho para funcionar corretamente.

Uma questão física

Um dos principais motivos pelos quais a Lei de Moore deve se esgotar em breve está relacionado às propriedades físicas do silício, material utilizado em uma imensa variedade de componentes eletrônicos (daí o termo Vale do Silício). Segundo o físico teórico Michio Kaku, em cerca de 10 anos o poder desse elemento vai ser esgotado completamente.

Segundo Kaku, o problema ocorre em dois campos: calor e vazamento. Ele afirma que, embora atualmente os processadores da Intel possuam uma camada externa de 20 átomos, esse valor não pode ser menor do que 5 átomos, ponto a partir do qual “está tudo terminado”.

O físico afirma que, a partir desse estágio, o calor gerado pelo processador será tão intenso que ele vai simplesmente derreter. A outra preocupação do profissional está relacionada ao vazamento de dados, já que, ao lidar com dispositivos com escala tão pequena, seria impossível determinar o posicionamento correto de cada elétron.

Kaku prevê que, embora cientistas provavelmente vão encontrar meios de estender a validade da Lei de Moore, o limite possível já está próximo. Segundo ele, isso vai resultar no investimento em computadores moleculares, que devem ser substituídos no final do século 21 por máquinas quânticas.

Broadwell: novo foco para a Intel

A maior prova de que a Lei de Moore não está mais dando os resultados esperados é a própria Intel, empresa cofundada pelo responsável por essa regra. Nos últimos anos, a companhia tem se focado cada vez mais em aprimorar a relação performance por watt de seus produtos, deixando de lado o investimento em poder bruto.

Embora isso possa ser atribuído em partes à ascensão dos mercados de dispositivos portáteis, que exigem pouca quantidade de energia para funcionar, o grande motivador por trás dessa decisão são as limitações físicas que os cientistas da empresa enfrentam.

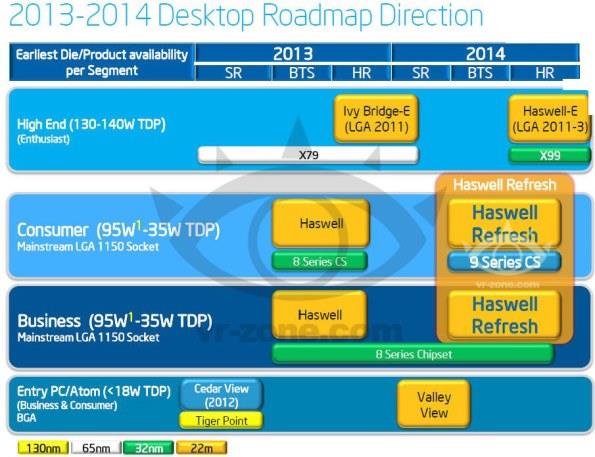

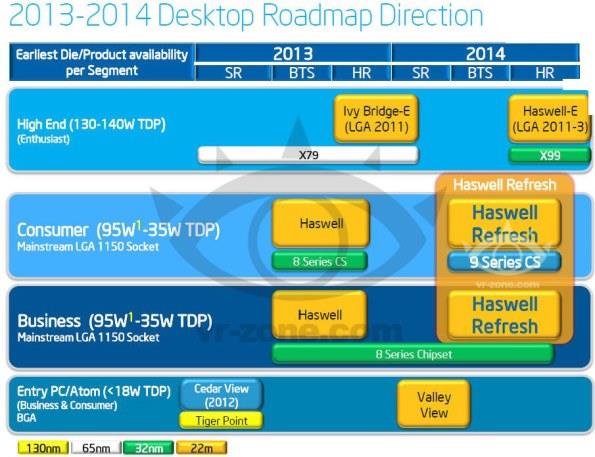

(Fonte da imagem: Reprodução/Hot Hardware)

(Fonte da imagem: Reprodução/Hot Hardware)

A próxima geração de chips produzidos pela companhia, conhecidos pelo codinome Broadwell, são um belo exemplo disso. Tudo indica que os novos processadores não devem apostar em um novo chipset, reaproveitando aquele que já é utilizado pela família de produtos Haswell.

Na prática, as CPUs pertencentes à nova linha devem empregar uma frequência de operação maior e passar a usar formas de 14 nanômetros em sua fabricação. O principal aumento de desempenho deve ser visto na GPU integrada ao novo chip, que deve ganhar ainda mais importância devido ao foco cada vez maior que a empresa está dando ao mercado de dispositivos móveis.

Documentos indicam que o processamento gráfico dos novos componentes deve ser 40% melhor do que aquele apresentado pela linha Haswell. Infelizmente, não há indícios de que a Intel vá começar a dar prioridade ao desenvolvimento de drivers mais eficientes, área na qual a companhia continua a pecar.

Mudança de rumo

Prova de que a Intel está planejando uma mudança de rumo são os indícios de que os produtos da linha Broadwell não devem acompanhar o soquete característico dos dispositivos fabricados pela empresa. Ao que tudo indica, as novas CPUs devem vir soldadas diretamente a placas-mães, o que acaba de vez com a possibilidade de realizar upgrades desse componente.

Embora a decisão deva assustar adeptos dos desktops tradicionais, ela faz bastante sentido para a companhia do ponto de vista comercial. Atualmente, é difícil convencer a maioria dos usuários de computadores tradicionais a investir em um novo processador usando seu poder de fogo como única justificativa — afinal, esse público não costuma fazer atividades que vão além de navegar na internet, assistir a vídeos em baixa definição e usar editores de texto.

(Fonte da imagem: Reprodução/PC World)

(Fonte da imagem: Reprodução/PC World)

Assim, trocar a versatilidade das peças tradicionais por uma arquitetura mais fechada que prioriza a eficiência energética faz bastante sentido. Como no mercado de dispositivos portáteis (que ainda está em expansão) não existe a cultura do “upgrade” de componentes individuais, não faz sentido apostar em tecnologias antiquadas que estão se mostrando pouco atrativas do ponto de vista comercial.

Isso não significa que a companhia deve abandonar o mercado de desktops, que, embora estagnado, continua sendo muito importante para ela. Ao que tudo indica, o que devemos ver é uma evolução mais lenta desse segmento, que passaria a testemunhar o lançamento de novos processadores com soquetes tradicionais em um ritmo mais lento do que o atual.

Para onde vamos agora?

O fim iminente do funcionamento da Lei de Moore, mais do que provocar a estagnação da indústria, pode significar uma mudança de rumo muito bem-vinda. Quando se leva em consideração que todo o mundo da tecnologia depende do mesmo elemento (o silício) há mais de 50 anos, é surpreendente termos conseguido avançar tanto.

Entre as soluções que estão sendo desenvolvidas para aumentar o poder bruto de processamento a nosso dispor, está a criação das chamadas “CPUs tridimensionais”. Assim como os seres humanos começaram a “empilhar” casas para economizar espaço (resultando na criação de prédios), empresas apostam no agrupamento de diversos chips como forma de encurtar a distância que uma informação precisa navegar para chegar a seu destino.

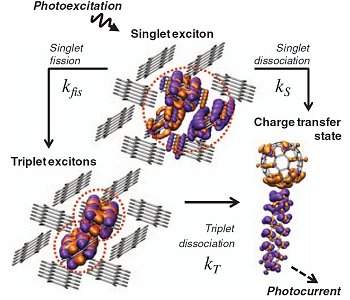

Já o MIT aposta na substituição de fios tradicionais por um sistema de lasers baseados no elemento germânio (Ge), que usam luzes infravermelhas para transmitir informações. “Conforme processadores ganham mais núcleos e componentes, os fios que os interconectam ficam congestionados e viram a parte fraca do sistema. Estamos usando fótons, em vez de elétrons, para fazer isso de uma forma melhor”, explica o pesquisador Jurgen Michel.

Ao substituir as ligações tradicionais por pequenos espelhos e túneis pelos quais a luz pode ser transmitida, a equipe conseguiu reduzir o consumo elétrico dos processadores e a quantidade de calor gerada por eles. Com o tempo, isso pode resultar na construção de CPUs com frequências surpreendentes que não sofrem com os problemas de superaquecimento vistos em componentes tradicionais.

Grafeno: substituto para o silício?

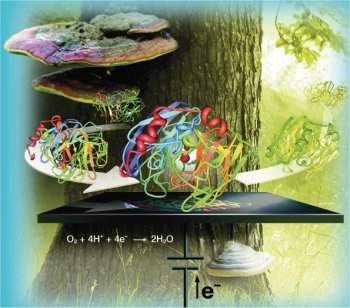

Outras opções envolvem o uso da tecnologia ReRam (conhecida popularmente como memresistores) e o desenvolvimento de chips programáveis, capazes de realizar operações de forma mais especializada. Porém, a maioria das apostas para o futuro da tecnologia se concentra em um elemento conhecido como grafeno.

(Fonte da imagem: Reprodução/SammyHub)

(Fonte da imagem: Reprodução/SammyHub)

Constituído por átomos de carbono arranjados em padrões hexagonais, o material se mostra um substituto perfeito para o silício. Entre suas vantagens, estão uma condução elétrica mais eficiente, a possibilidade de utilizá-lo em escala ainda menor e o fato de que ele consome uma quantidade ínfima de energia.

Embora seja conhecido desde a década de 70, somente a partir de 2004 é que as pesquisas do elemento realmente começaram a ser feitas de forma intensa. Infelizmente, o estágio atual de desenvolvimento da tecnologia ainda se mostra bastante rudimentar, o que significa que produzir chips com o material ainda se mostra algo muito dispendioso e um pouco difícil de aplicar em escala comercial — situação que lembra bastante o início dos processadores feitos com silício.

Evolução que deve continuar

Mesmo que o potencial da Lei de Moore esteja chegando a seu final, isso não significa que o mundo da tecnologia deva parar de evoluir. Tal como nós rimos de nossos pais e avós que ficavam abismados com o poder dos primeiros computadores e dependiam de disquetes para armazenar dados, nossos filhos e netos provavelmente vão achar estranho o fato de nos surpreendermos com smartphones e ainda dependermos tanto de discos rígidos para armazenar dados.

Fonte: MemeBurn, PC World, SemiAccurate, Phys.org, CNET, TechSpot

(Fonte da imagem:

(Fonte da imagem:  (Fonte da imagem:

(Fonte da imagem:  (Fonte da imagem:

(Fonte da imagem:  (Fonte da imagem:

(Fonte da imagem:  (Fonte da imagem:

(Fonte da imagem:  (Fonte da imagem:

(Fonte da imagem:  A tecnologia de metais líquidos deverá ser útil para conectar componentes eletrônicos em chips 3D. [Imagem: Michael Dickey]

A tecnologia de metais líquidos deverá ser útil para conectar componentes eletrônicos em chips 3D. [Imagem: Michael Dickey]

Silício, o coração do mundo eletrônico. (Fonte da imagem:

Silício, o coração do mundo eletrônico. (Fonte da imagem:  Circuito eletrônico. (Fonte da imagem:

Circuito eletrônico. (Fonte da imagem:  Molibdenite é um dos possíveis substitutos do silício. (Fonte da imagem:

Molibdenite é um dos possíveis substitutos do silício. (Fonte da imagem: