Por Jonathan D. Machado, 25 de Novembro de 2011

Entenda por que os aparelhos portáteis são tão úteis quanto os computadores de mesa e, mesmo assim, não têm qualquer cooler interno.

Há tempos que smartphones e tablets deixaram de ser itens de luxo para se tornarem aparelhos indispensáveis para muitos brasileiros, e não por acaso. Afinal, estes gadgets podem ser tão úteis quanto notebooks e computadores de mesa, com um bom poder de processamento e dezenas de sensores que os tornam verdadeiros canivetes suíços digitais.

Smartphones modernos são como computadores portáteis, mas sem cooler (Fonte da imagem: Divulgação Samsung)

Smartphones modernos são como computadores portáteis, mas sem cooler (Fonte da imagem: Divulgação Samsung)

Apesar de toda essa tecnologia que cabe no bolso, um detalhe sobre esses gadgets passa despercebido para muitos usuários: você não vê nenhuma ventoinha neles, diferente do que acontece com seus primos maiores.

O Tecmundo preparou esta matéria que vai ajudar você a entender melhor o motivo de não haver aberturas por onde o ar quente é soprado para fora nos tablets e smartphones. Confira!

Energia gera calor

Para entender os motivos da eficiência na manutenção da temperatura dos portáteis, primeiro precisamos entender o que faz os computadores maiores precisarem de tantos coolers. A primeira diferença notada entre os dois mundos é o espaço que eles ocupam. Claro, não é o tamanho maior que faz os desktops serem mais quentes, mas você logo verá que a relação é bastante grande.

Desktops e a maioria dos notebooks ainda são muito dependentes de componentes mecânicos para operar, como leitores de CD e discos rígidos que têm várias partes móveis. Diferente de circuitos eletrônicos, a miniaturização de mecanismos físicos é muito mais difícil, fazendo o patamar mínimo para o tamanho deles ser bem mais alto. Tablets e smartphones confiam apenas em circuitos puramente eletrônicos para quase todas as suas funções.

Interior de um HD (Fonte da imagem: Divulgação Samsung)

Interior de um HD (Fonte da imagem: Divulgação Samsung)

Movimentar partes móveis é um trabalho energeticamente custoso, o que explica o tamanho maior de um dos componentes que mais gera calor nos computadores: fontes de energia. As fontes de alimentação são as responsáveis por modular a corrente alternada da tomada e transformá-las nas diferentes correntes contínuas que alimentam os componentes do computador.

Quanto maior a variabilidade e exigência energética dos componentes, mais capacitores, transistores e mosfets a fonte precisa, todos gerando sua própria parcela de calor. Em suma, é possível afirmar que o primeiro motivo que faz os desktops e notebooks ficarem mais quentes é a maior quantidade de energia correndo dentro deles.

Assim como nas CPUs, todas as fontes precisam de ventoinhas (Fonte da imagem: Divulgação XFX)

Assim como nas CPUs, todas as fontes precisam de ventoinhas (Fonte da imagem: Divulgação XFX)

Nos portáteis, a fonte está quase completamente ausente, já que são alimentados por baterias que armazenam a energia na tensão e modulação certa. A necessidade de uma fonte que fica entre o gadget e a tomada da parede ainda existe para os momentos em que o aparelho é carregado, apesar de ser totalmente externa.

É importante notar também que, quanto mais difícil for fabricar um componente, mais caro ele fica. Por isso, os fabricantes não investem tanto na miniaturização e eficiência energética de notebooks e, principalmente, desktops, porque essa não é uma necessidade primária para o mercado.

Arquitetura diferenciada

Outro motivo que faz os gadgets exigirem menos energia para operar é a arquitetura mais especializada. Notebooks e desktops são feitos para serem robustos e altamente escalonáveis, sempre tentando manter a compatibilidade com o maior número de componentes possíveis.

Placa-mãe de um desktop (direita) comparada à de um iPad

Placa-mãe de um desktop (direita) comparada à de um iPad

Isso é ainda mais evidente em computadores mais “hardcore”, com placa-mãe com mais de dez conectores USB, meia dúzia de SATAs, duas interfaces de rede, várias PCIs, slots de memória extra e muitos outros conectores. Manter suporte a todos estes equipamentos também aumenta o fluxo de energia entre as placas e chips controladores, contribuindo para o calor interno.

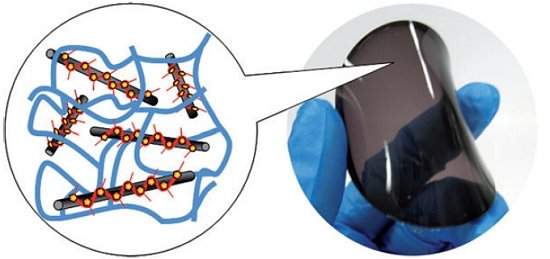

Já os tablets são altamente focados e não são projetados para dar suporte a quase nenhum componente extra além do que já está encaixado na placa principal. Dessa forma, os fabricantes podem limitar os tablets e smartphones a terem apenas uma motherboard que já inclui o processador, a memória RAM e demais controladores.

System-on-a-chip TEGRA3: CPU, GPU, ponte norte, ponte sul e controlador de memória (Fonte da imagem: Divulgação NVIDIA)

System-on-a-chip TEGRA3: CPU, GPU, ponte norte, ponte sul e controlador de memória (Fonte da imagem: Divulgação NVIDIA)

Toda essa especialização e controle sobre os diferentes componentes do gadget é um prato cheio para a prática de se unir o maior número possível de controladores dentro de um único circuito integrado, os chamados system on a chip. Novamente, reduzir o número de CIs diminui o consumo energético e, consequentemente, a produção de calor.

Menores e mais eficientes

Por último, mas não menos importante, está o fato de que a exigência de processamento para os dispositivos móveis é muito menor. Por mais poderoso que um iPad ou tablet com a última versão do Android possa parecer, dificilmente ele poderia rodar (tranquilamente) um aplicativo do nível do Microsoft Word 2010, com todas as suas centenas de ferramentas e dependências.

Afinal, gadgets portáteis são destinados para aplicações portáteis, com poucas informações aparecendo simultaneamente em uma tela bem menor do que a de um notebook ou desktop. Somando isso ao fato de que o sistema operacional também é mais simplificado, o resultado é um desempenho satisfatório mesmo com o hardware menos poderoso.

Outro fator que diminui muito a produção de calor é a arquitetura do componente que normalmente é o que mais esquenta: o processador. As CPUs dos tablets são feitas para abranger o maior número possível de funções com o mínimo de transístores, o que contribui muito para a economia de energia.

A baixa emissão de calor de todos estes componentes modernos permite que apenas dissipadores passivos sejam o suficiente para arrefecer o aparelho, eliminando a necessidade de ventoinhas mecânicas.

A bateria agradece

Perceba que quase todas as vantagens dos tablets e smartphones que foram citadas até agora receberam ênfase primária em sua eficiência energética, depois no calor gerado. Essa abordagem não ocorreu por acaso, afinal, quanto menos energia ele consumir, mais tempo vai durar a bateria do gadget, além de mantê-lo frio por mais tempo.

Placa principal de um iPad (Fonte da imagem: Divulgação BricoJapan)

Placa principal de um iPad (Fonte da imagem: Divulgação BricoJapan)

Tamanha é a preocupação com o consumo de energia dos portáteis que os fabricantes têm optado em usar apenas componentes de alta eficiência não só em processadores e unidades de armazenamento, mas no aparelho como um todo. Basta olhar novamente para a placa principal do iPad (acima) para perceber que capacitores de alumínio (aqueles redondos) deram lugar a alguns poucos capacitores de tântalo e muitos microchips de silício.

Além disso, as próprias ventoinhas são componentes mecânicos que precisam consumir energia para funcionar, consequentemente, o próprio dispositivo usado para arrefecer o aparelho é um agente que contribuí com o calor, algo completamente indesejado.

Fonte: Tecmundo

Lumus tranforma óculos em telas de vídeo em HD. (Fonte da imagem:

Lumus tranforma óculos em telas de vídeo em HD. (Fonte da imagem:

Esboço do armamento laser (Fonte da imagem:

Esboço do armamento laser (Fonte da imagem:  (Fonte da imagem:

(Fonte da imagem:

Quadro comparativo retirado do estudo.

Quadro comparativo retirado do estudo.